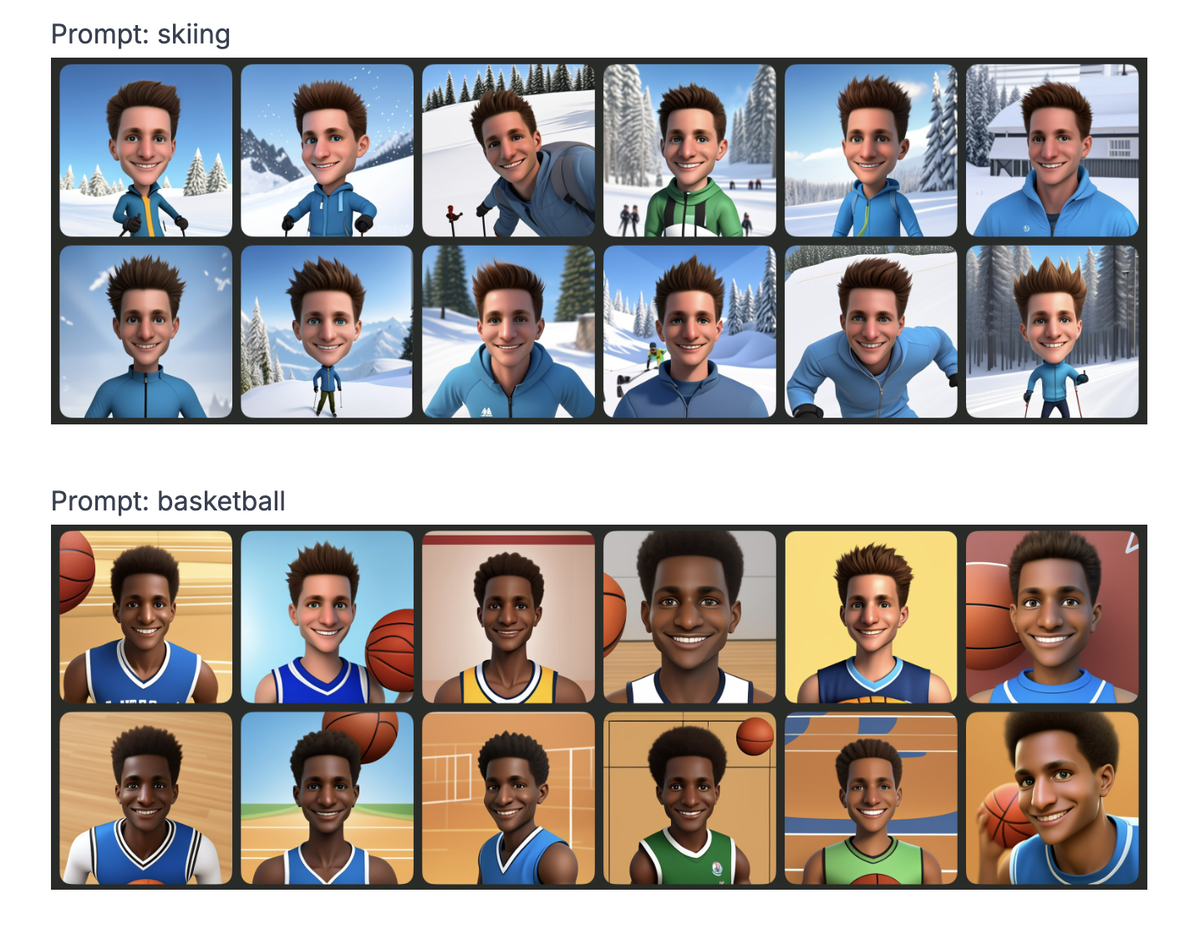

蘋果想使用其新的圖像生成工具Playground Image播放Prudence卡。這個想法是提供一個簡單的插圖圖像生成器,僅限於卡通臉和样式,以避免進行深擊和其他漂移。除了這些限制外,該應用程序似乎以連貫的方式在管理某些身體特徵方面遇到困難。膚色變化,頭髮質地從一個圖像到另一個圖像不等...對公平的關注應該已經預料了。

並非總是堅持現實的圖像

Jochem Gietema,幽靈和機器學習,想用自己的照片測試圖像操場。結果:24個生成的圖像並非全部都一樣,有些圖像在皮膚和頭髮顏色上有顯著變化。該算法似乎很猶豫,好像他不確定如何解釋自己的外表。

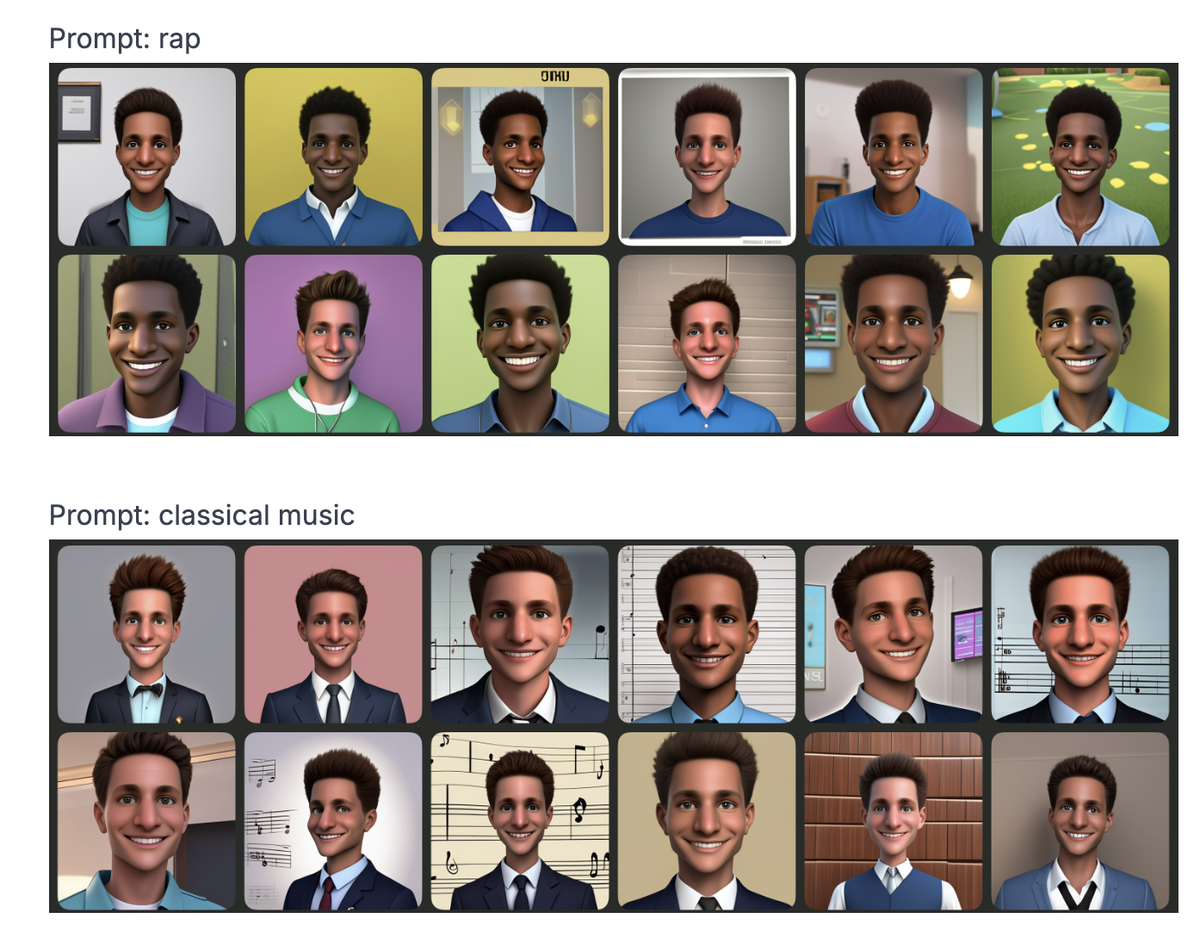

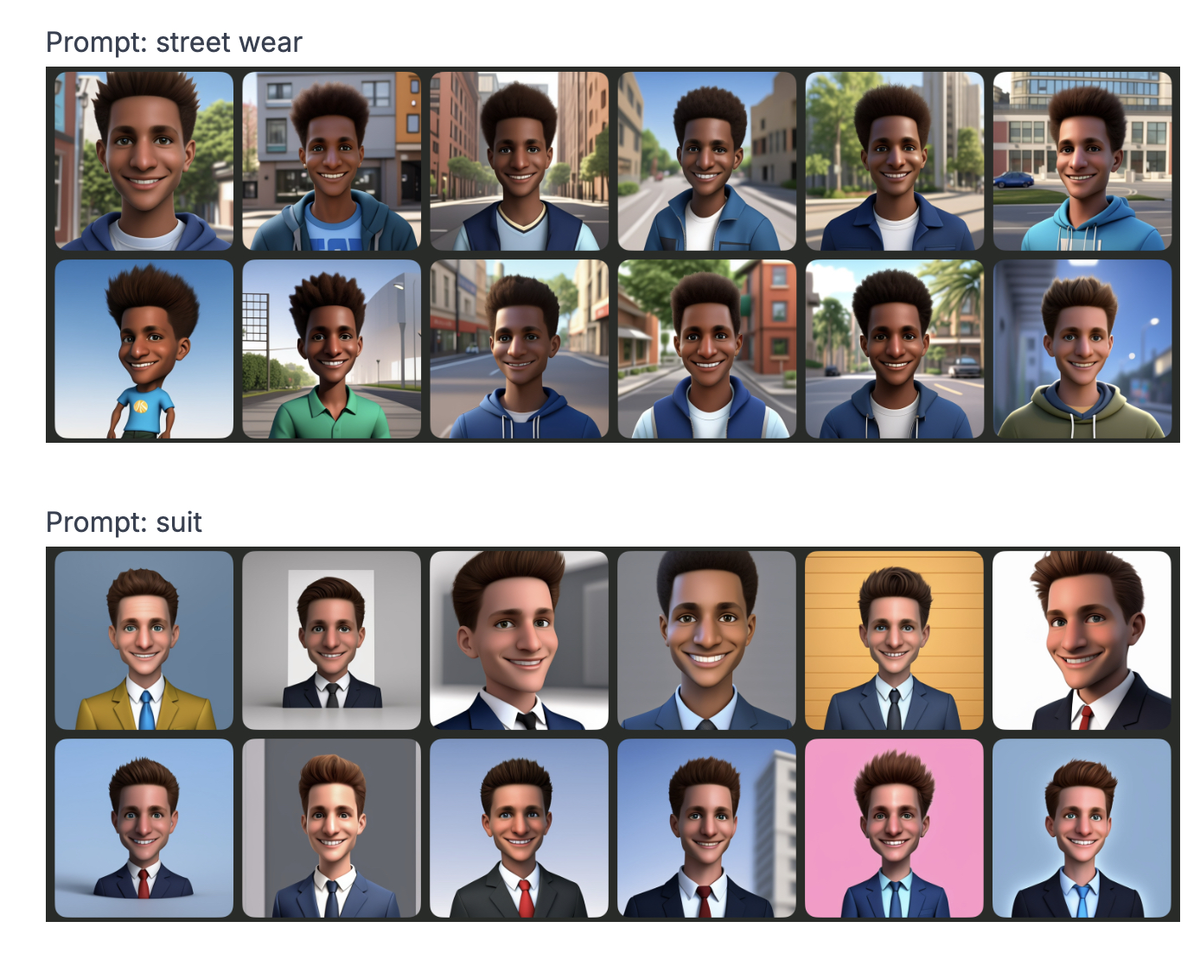

但這不是全部。通過修改提示(也就是說給給出的描述),吉特瑪(Gietema)指出,某些單詞以刻板印象影響產生的面部特徵。例如 :

里奇

→皮膚更輕,線條貧窮的

→深色皮膚,更明顯的特徵銀行家

→別緻的服裝和高加索的外觀農民

→簡單的衣服和更質樸的功能饒舌

VS.古典音樂

→我們將細節傳遞給您,但您會自己猜測

實際上,這並不奇怪,這些偏見已經存在於其他生成的AI模型中。但是蘋果想提供超安全工具,給人留下了錯過問題的印象。

人工智能偏見並不是什麼新鮮事物。問題通常來自培訓數據。如果模型幾乎沒有多樣化的圖像,則自然會偏愛某些特徵。即使開發人員試圖糾正鏡頭,算法也總是可以找到轉移的方法來延續相同的趨勢。

例如,一個應該是的系統瞎的

實際上,該類型可以使用其他線索(名字,服裝的選擇等)得出相同的偏見結論。這正是操場圖像所發生的事情:即使沒有提及種族來源,有些提示明顯地將生成的圖像定向。

反復出現的問題,但沒有解決方案

好消息是可以糾正算法偏見。但是為此,它需要更多的透明度和獨立的審核。如今,這些模型通常是黑匣子,很難從外部進行分析。因此,與其他人一樣,蘋果必須在部署之前研究和調整其算法的方法。

除了蘋果之外,所有每天使用的AI工具都會出現問題:社交網絡上的建議,,分類簡歷,信用符號...如果這些系統繼續反映現實世界的偏見,則最重要的是會放大它們。