苹果想使用其新的图像生成工具Playground Image播放Prudence卡。这个想法是提供一个简单的插图图像生成器,仅限于卡通脸和样式,以避免进行深击和其他漂移。除了这些限制外,该应用程序似乎以连贯的方式在管理某些身体特征方面遇到困难。肤色变化,头发质地从一个图像到另一个图像不等...对公平的关注应该已经预料了。

并非总是坚持现实的图像

Jochem Gietema,幽灵和机器学习,想用自己的照片测试图像操场。结果:24个生成的图像并非全部都一样,有些图像在皮肤和头发颜色上有显着变化。该算法似乎很犹豫,好像他不确定如何解释自己的外表。

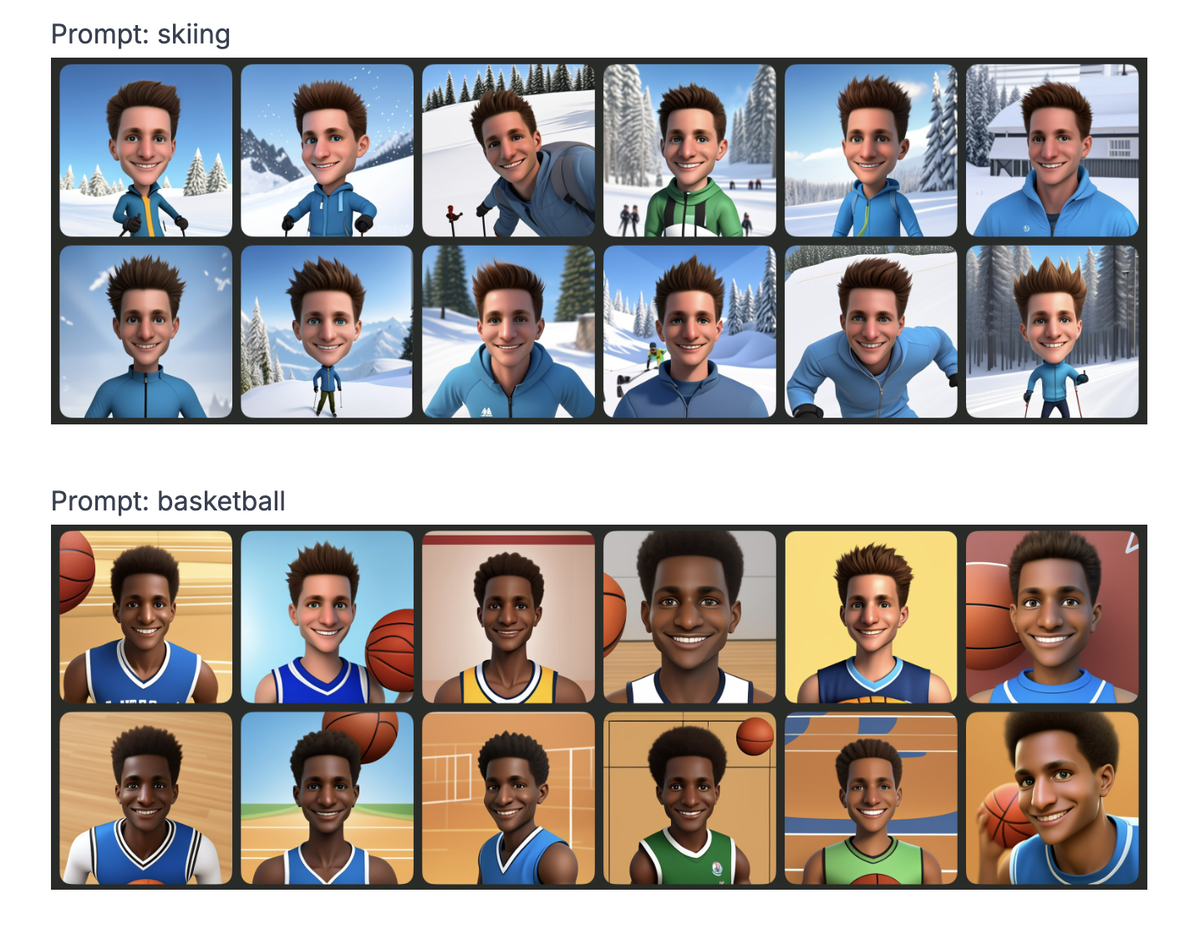

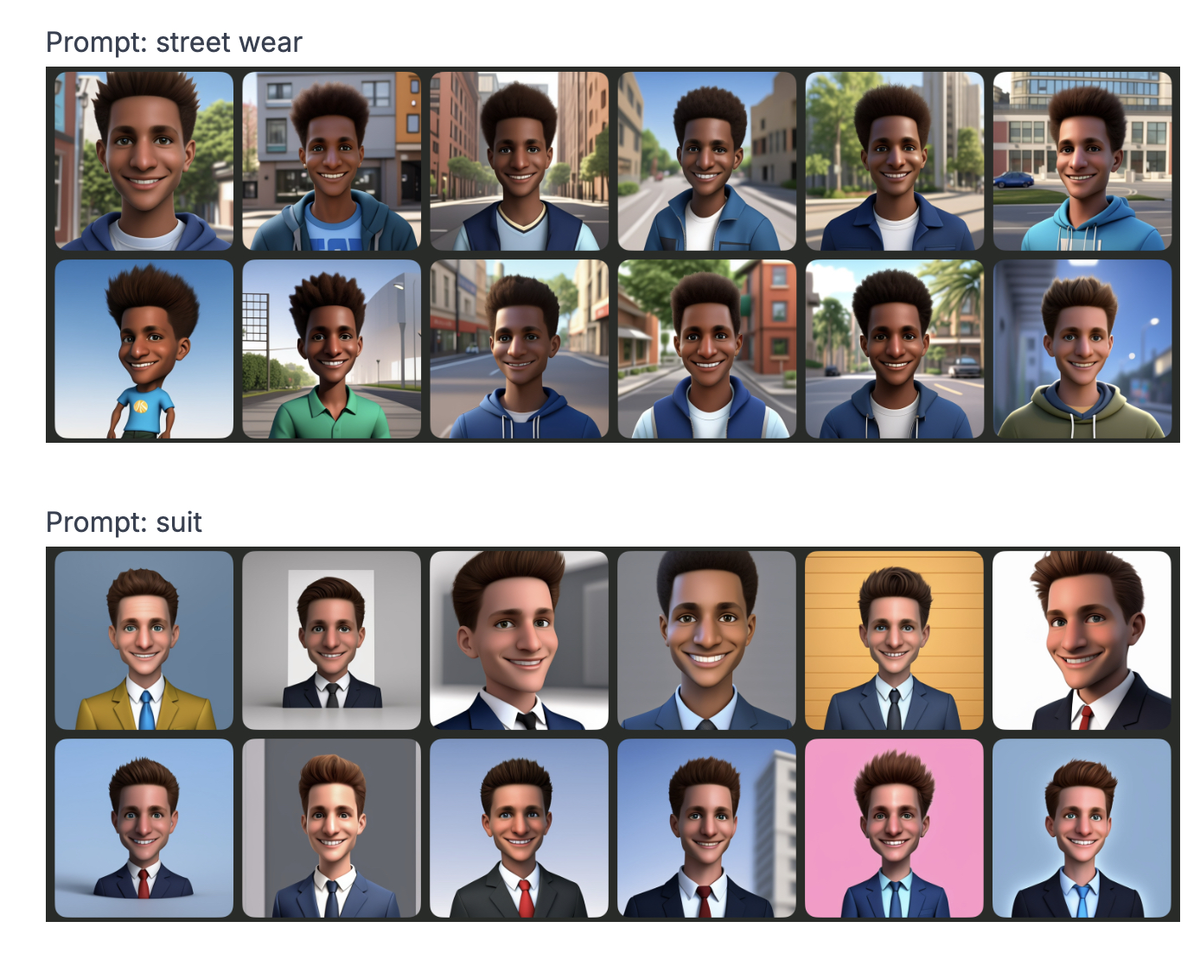

但这不是全部。通过修改提示(也就是说给给出的描述),吉特玛(Gietema)指出,某些单词以刻板印象影响产生的面部特征。例如 :

里奇

→皮肤更轻,线条贫穷的

→深色皮肤,更明显的特征银行家

→别致的服装和高加索的外观农民

→简单的衣服和更质朴的功能说唱

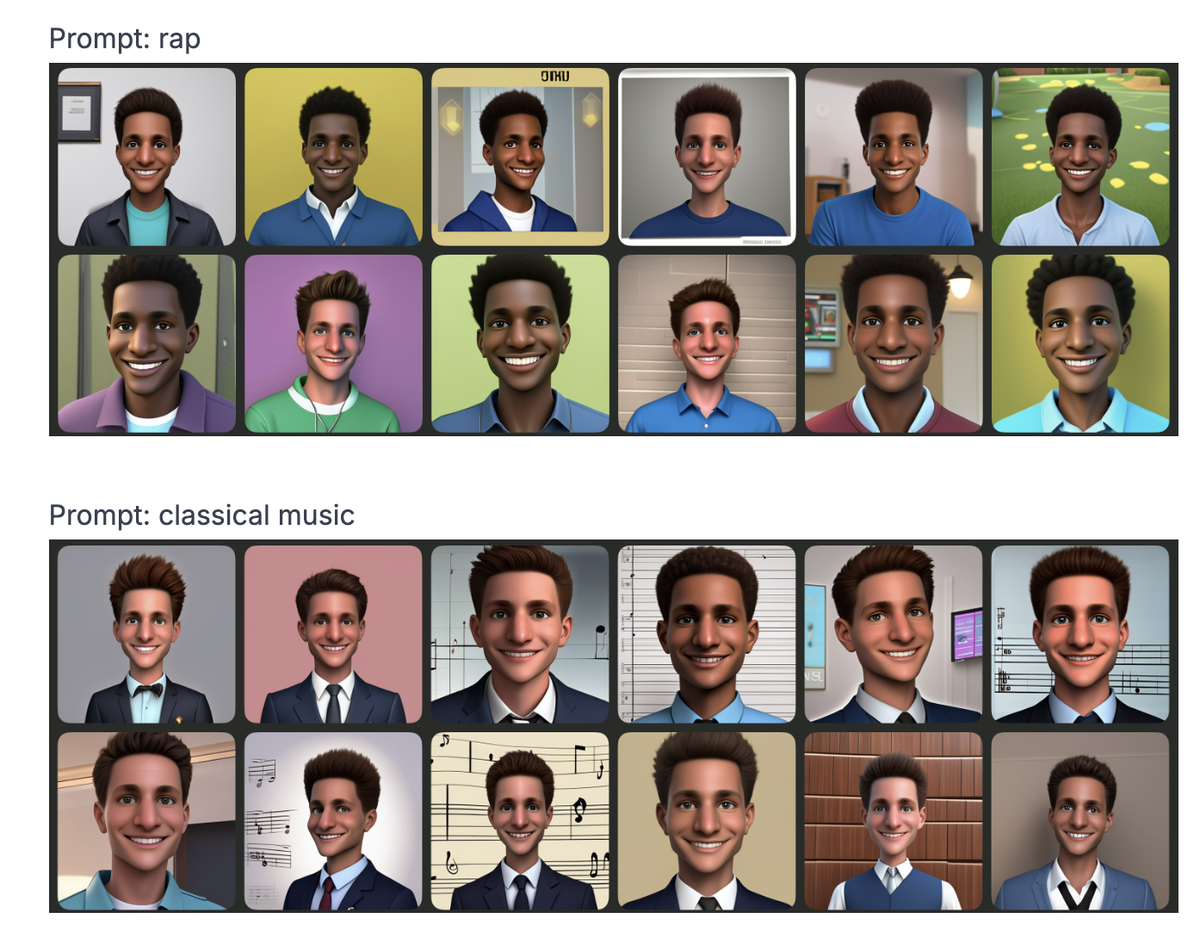

VS.古典音乐

→我们将细节传递给您,但您会自己猜测

实际上,这并不奇怪,这些偏见已经存在于其他生成的AI模型中。但是苹果想提供超安全工具,给人留下了错过问题的印象。

人工智能偏见并不是什么新鲜事物。问题通常来自培训数据。如果模型几乎没有多样化的图像,则自然会偏爱某些特征。即使开发人员试图纠正镜头,算法也总是可以找到转移的方法来延续相同的趋势。

例如,一个应该是的系统瞎的

实际上,该类型可以使用其他线索(名字,服装的选择等)得出相同的偏见结论。这正是操场图像所发生的事情:即使没有提及种族来源,有些提示明显地将生成的图像定向。

反复出现的问题,但没有解决方案

好消息是可以纠正算法偏见。但是为此,它需要更多的透明度和独立的审核。如今,这些模型通常是黑匣子,很难从外部进行分析。因此,与其他人一样,苹果必须在部署之前研究和调整其算法的方法。

除了苹果之外,所有每天使用的AI工具都会出现问题:社交网络上的建议,,分类简历,信用符号...如果这些系统继续反映现实世界的偏见,则最重要的是会放大它们。