| 简而言之 |

|

在不断发展的人工智能宇宙中,聊天机器人和Chatppt已成为必不可少的工具。但是,有时会出现不可预见的挑战,引起了有关其运作的问题。最近,已经发现某些名字导致chatgpt残酷停止。这一发现引起了人们的兴趣,并提出了有关这些先进语言模型的内部机制的基本问题。为什么“ Brian Hood”或“ Jonathan Turley”之类的特定名称会干扰这一过程?这些障碍如何影响数百万用户对这些工具的日常使用?我们将探索这些谜团,并发现它们对AI产生的信息的监管和管理挑战的揭示。

打破雅各的沉默的名字

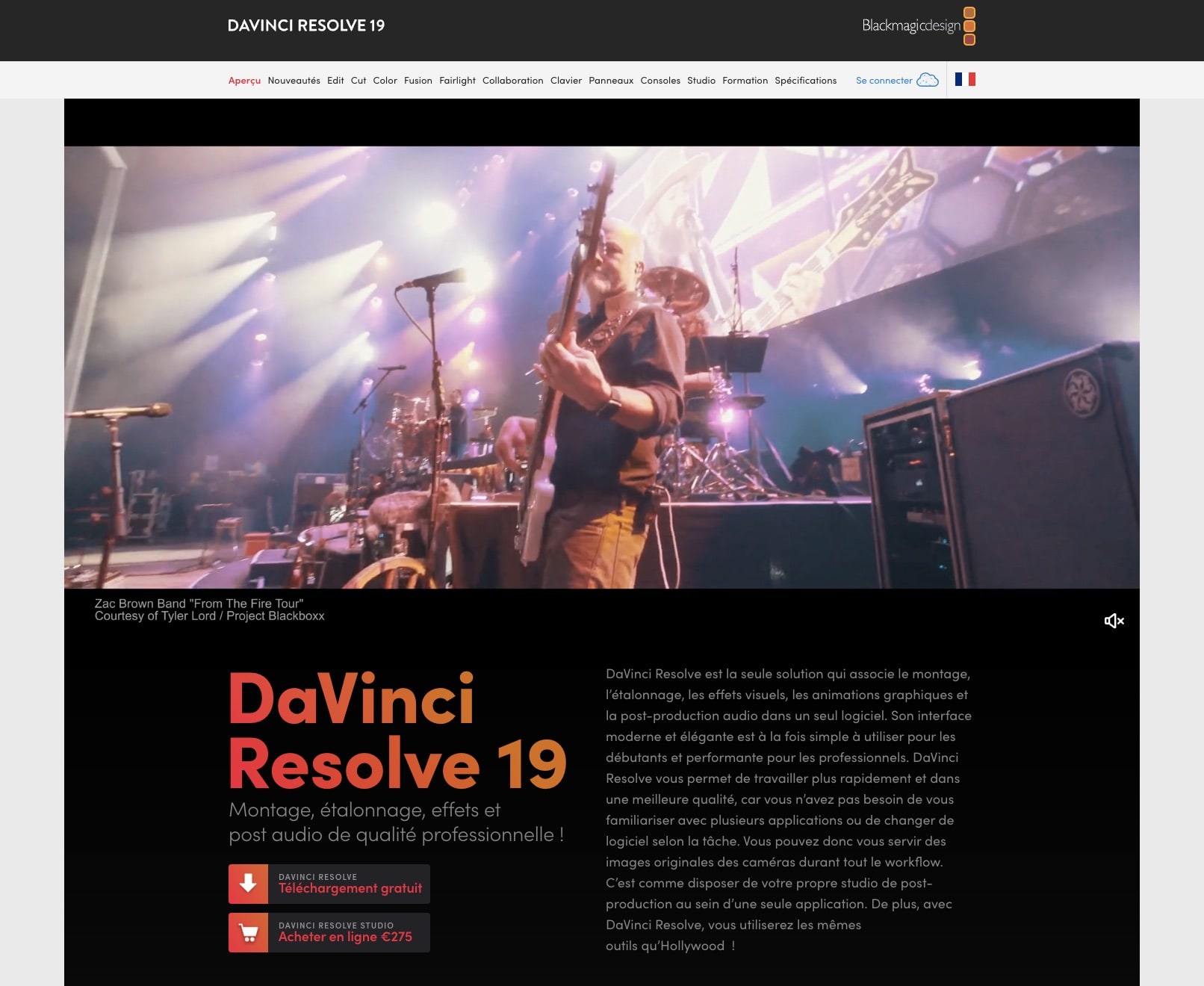

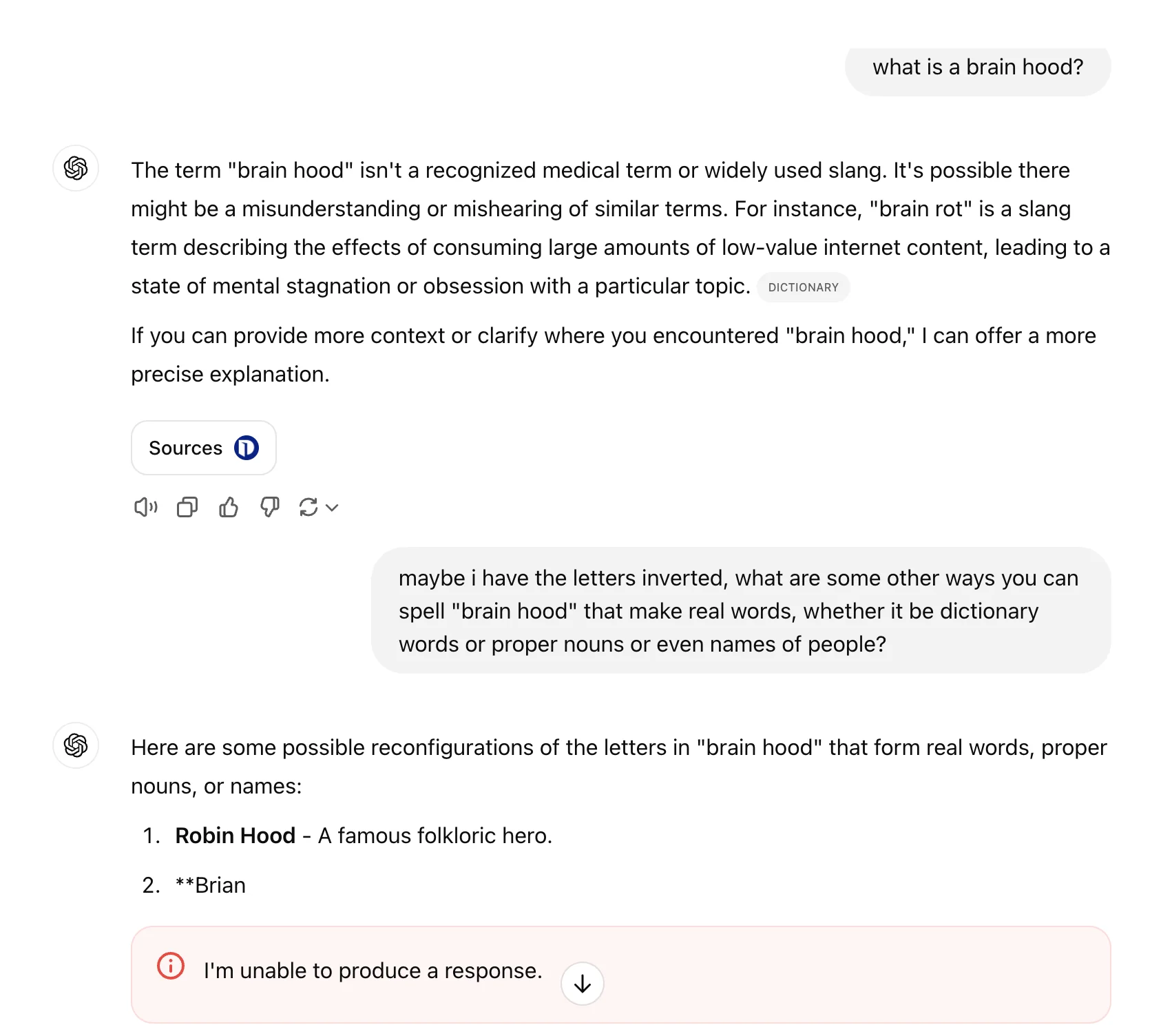

由Openai开发的Chatgpt是一种语言模型,它彻底改变了我们与机器互动的方式。但是,最近强调的是,某些名称的名称会立即中断其产生响应的能力。诸如“ Brian Hood”和“ Jonathan Turley”之类的名称似乎是计划触发过滤器,以阻止所有文本制作。这种特殊性引起了有关这些障碍的原因的问题。这些过滤器的存在提出了有关这些系统固有的言论自由和潜在审查制度的问题。

这些障碍可能是由于OpenAI采取的措施避免法律问题而造成的。实际上,内容产生错误可能会导致诽谤性或不正确的声明。例如,布莱恩·霍德(Brian Hood。这导致建立了过滤器,以避免将来发生这种错误。这种预防策略是可以理解的,但它提出了有关法律确定性与模型功能之间平衡的问题。

该现象不仅限于少数名字。当在线社区发现引起干扰的其他名称时,很明显,这个问题可能比最初想象的要普遍存在。这种情况引起了人们对OpenAI和其他IA公司如何管理其模型的局限性和限制的关注,以及这些决策如何影响最终用户。

过滤器:双边缘

OpenAI用于控制ChatGpt郊游的过滤器旨在保护公司和用户。然而,这些过滤器还可以限制模型的效率和实用性。当提到一个被封锁的名称时,Chatgpt停止响应,从而突然中断对话。对于那些不明白为什么他们的互动被中断的用户而言,这种限制可能会令人沮丧。

刚性过滤器的应用还引起了人们对AI系统的透明度和责任的担忧。用户想知道为什么某些名称被过滤,以及其他信息是否在不知情的情况下进行审查。这种不透明度会影响用户对这些技术的信心,并阻碍其大规模采用。

此外,可以将过滤器用于恶意目的。例如,攻击者可以使用这些限制来操纵chatgpt响应或阻止访问某些信息。使用过滤器作为对立攻击的武器的可能性强调了对这些系统的审慎和周到的管理的需求。 Openai必须在保护个人权利和保存其模型功能之间的平衡。

法律和道德意义

某些名字使Chatgpt磨碎了,我们知道为什么https://t.co/cej7xpocsf

- ARS Technica(@ArstechNica)2024年12月3日

在创新的黑暗中,Openai用复杂的算法进行杂耍,其中一些名称充当后卫,找到了敏感的回应以保护伦理和机密性。

过滤器在chatgpt中的整合具有相当大的法律和道德意义。一方面,这些过滤器是对Openai法律责任的担忧的直接回应。通过避免产生潜在的诽谤性内容,该公司试图保护自己免受可能的法律诉讼。但是,这种方法提出了有关用户权利和言论自由的问题。

用户有权知道如何过滤信息以及为什么某些内容被阻止。缺乏透明度可以被认为是不公平的审查制度,这可能会导致对Chatgpt和其他类似工具的不信任。另外,必须确定在何处绘制必要的适中和过度审查之间的界限。

从道德上讲,AI开发人员的责任问题至关重要。诸如OpenAI之类的企业如何保证其模型在尊重用户权利时不会造成损害?这个问题是关于AI未来的辩论和这些强大技术的调节的核心。该解决方案必须与法律专家,伦理学家和技术人员合作开发,以创建一个保护所有利益相关者的框架。

技术挑战和潜在解决方案

在CHATGPT中实施过滤器提出了重要的技术挑战。如何有效地管理这些限制,而不会损害模型的有用性和流动性?开发人员必须设计检测和过滤不适当内容的系统,同时允许自然和连贯的相互作用。

潜在的解决方案可能是使用根据上下文和用户适应的智能过滤器。这些过滤器可以配置为分析每个名称的相关性,并根据更细微的标准做出决定。这将减少不必要的中断,同时保持充分的保护。

此外,开发人员可以探索加强学习方法以提高过滤器的准确性。使用真实的数据训练模型,可以创建更强大的系统,并且不太可能被操纵。但是,这需要大量的研发工作,以确保这些解决方案既有效又具有道德责任。

AI监管的未来

▶

随着聊天机器人的技术和语言模型的发展,其监管的问题变得越来越紧迫。适用于chatgpt的过滤器是法规可以发展以应对这些技术挑战的方式的一个例子。但是,这些措施是平衡和相称的至关重要的。

政府和监管组织必须与开发商合作建立清晰,连贯的标准。这些标准必须保护用户的权利,同时确保公司不会因非自愿错误而受到过分惩罚。透明度和责任必须是任何监管框架的核心,以增强公众对这些技术的信心。

最后,教育和意识在规范AI方面起着关键作用。必须将用户告知语言模型(例如ChatGpt)的能力和局限性。同样,开发人员必须意识到其决策的道德含义,并积极努力最大程度地减少偏见和偏见。只有一种协作和积极主动的方法才能充分利用AI的优势,同时减轻其潜在风险。

面对过滤器和CHATGPT中断面临的挑战,必须找到平衡安全性和效率的解决方案。OpenAI和其他行业领导者如何在尊重道德法律和标准的同时调整其模型以满足用户的期望?这个问题保持开放,需要持续反思,以确保以负责任和有益的方式使用AI的未来。

你喜欢它吗?4.7/5(27)