FP16 和 FP8 GPU 指南:深入探讨低精度 AI 加速

人工智能和高性能计算的世界正在经历一场巨大的转变。随着对计算能力的需求猛增,业界正在放弃传统的 32 位精度 (FP32),转而拥抱 FP16、BF16 和尖端 FP8 等低精度格式的革命性效率。这种转变不仅仅是增量更新;这是一个根本性的变化,可以训练大规模模型,加速科学发现,并使下一代人工智能变得可行。在这份综合报告中,我们将解构这些格式背后的技术,探讨它们对现实世界的影响,分析 NVIDIA、AMD 和 Intel 等硬件巨头之间的战略战,并提供直接比较,看看谁在低精度竞赛中处于领先地位。

低精度革命:FP16 和 FP8 GPU 加速分析 | GigXP.com

针对 AI 和 HPC 的 FP16 和 FP8 GPU 加速的架构和市场分析。

向较低精度的转变

单精度

基线:高精度、高成本

1 倍速度

半精度

双倍吞吐量,一半内存

2 倍速度

四分之一精度

AI 模型大幅加速

4x+ 速度

第八精度

未来:极高的推理效率

8 倍以上速度

人工智能的不断扩张引发了计算危机。为此,业界已转向低精度数字格式,主要是 16 位 (FP16) 和 8 位 (FP8)。这一转变代表了现代计算中最重要的架构发展之一,使具有数万亿个参数的模型成为可能,而这在以前是不可行的。

技术基础

解构浮点格式

浮点数由符号、指数(数值)和尾数(精度)组成。指数位和尾数位之间的权衡定义了格式在动态范围和精度之间的平衡。虽然 FP16 使用的指数位比 FP32 少,因此很容易出现梯度消失,但 Google 的 BF16 (BFloat16) 格式保留了 FP32 的 8 个指数位,以牺牲精度为代价保留了动态范围。这使得 BF16 对于训练特别有效。

为什么要使用降低的精度?

增加吞吐量

每秒执行的运算量增加 2 倍到 4 倍,显着加速人工智能核心的矩阵数学。

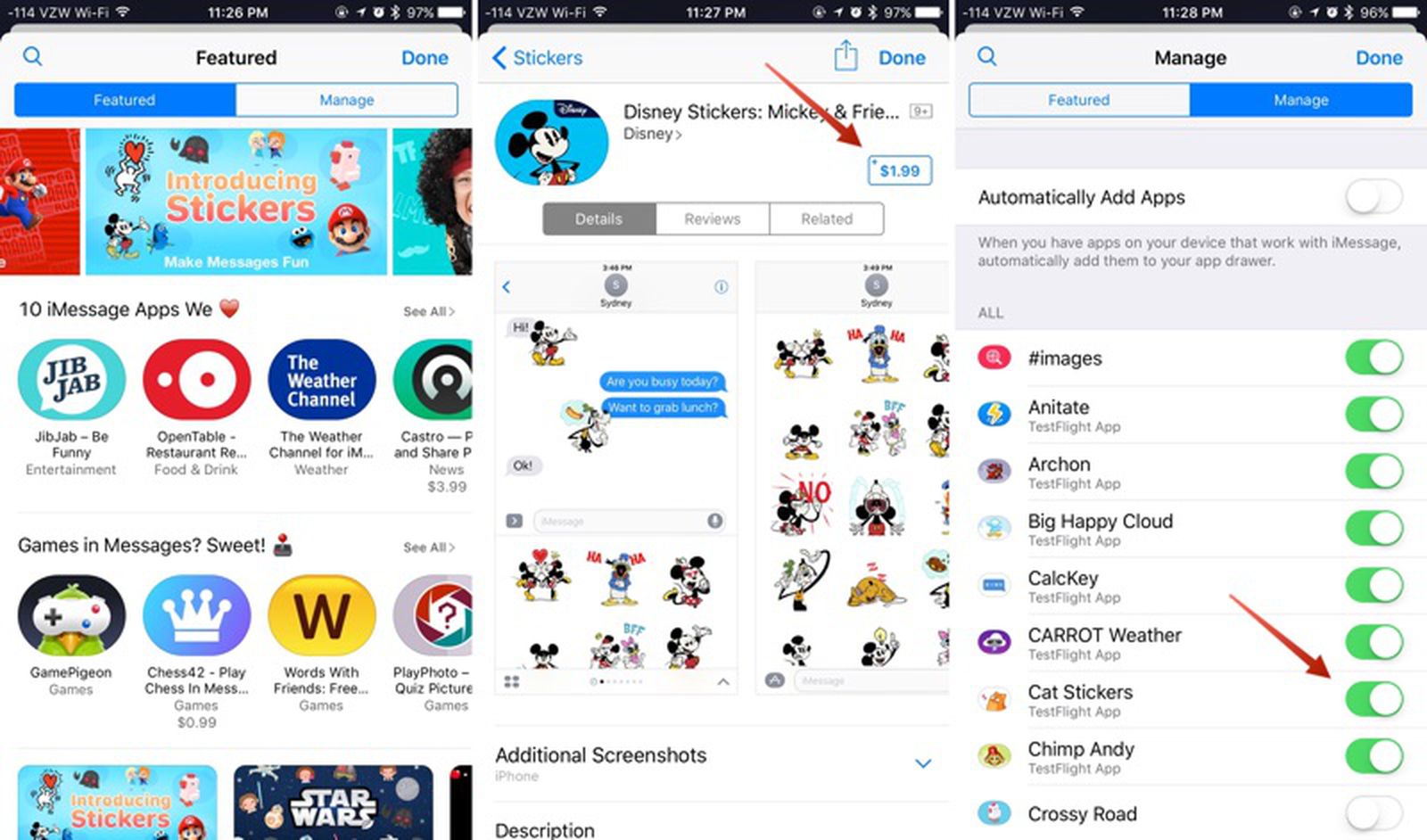

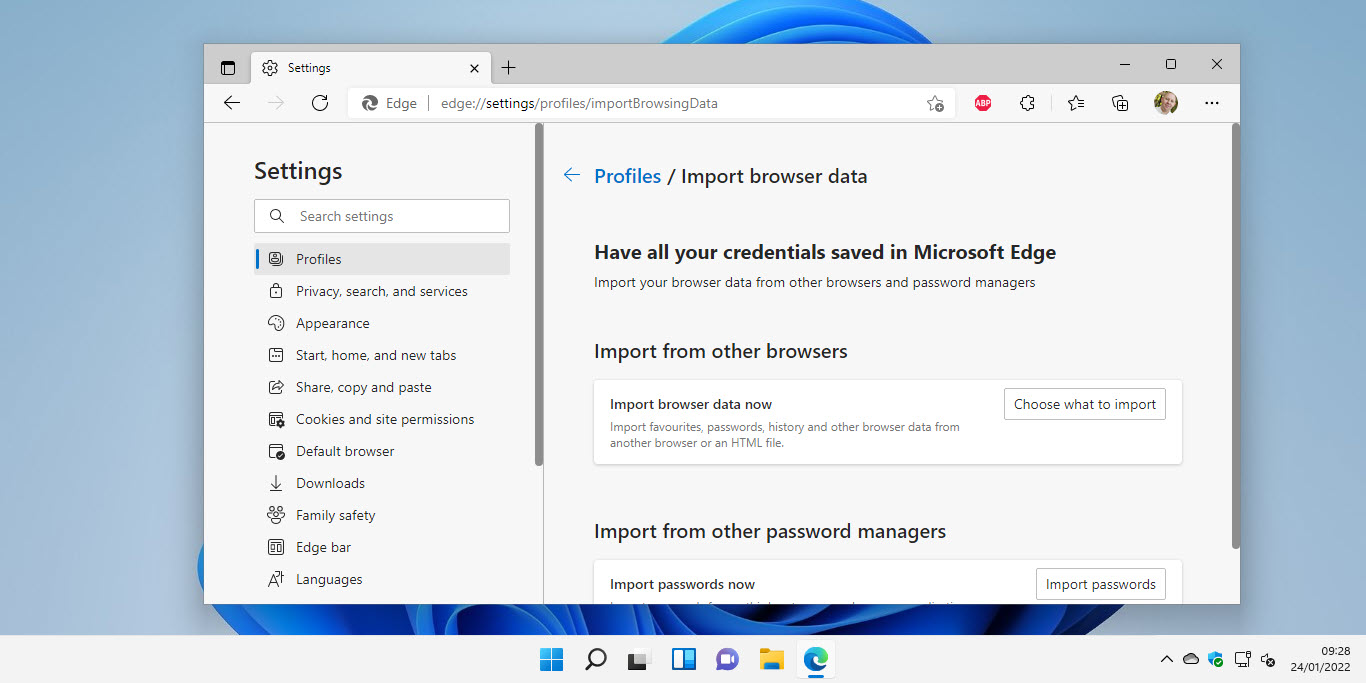

另请阅读:Windows 11 Home 上的 SMB over QUIC — 深入探讨

减少内存使用

将内存需求减半或四分之一,从而在相同的硬件上允许更大的模型和更大的训练批量大小。

提高能源效率

不太复杂的计算和减少的数据移动可以大幅降低功耗,使大规模人工智能更具可持续性。

可视化内存和带宽增益

FP32(基线)

100GB

内存占用

FP16/BF16

50GB

缩小 2 倍

FP8

25GB

缩小 4 倍

内存使用量的减少还意味着要移动的数据更少,从而有效地增加内存带宽并减少延迟。

混合精度训练

为了在不牺牲准确性的情况下获得较低精度的好处,使用了一种称为混合精度训练的技术。这是确保数值稳定性的三部分策略。

FP32

1. 掌握重量

维护权重的高精度副本。

→

FP16

2. 快速计算

使用快速半精度进行前向/后向传递。

→

损失缩放

3. 防止下溢

尺度损失以保持小梯度的可表示性。

复制

# PyTorch 自动混合精度 (AMP) 示例

import torch

from torch.cuda.amp import autocast, GradScaler

# Initialize scaler

scaler = GradScaler()

for data, label in data_loader:

optimizer.zero_grad()

# Cast operations to FP16/BF16

with autocast():

output = model(data)

loss = loss_fn(output, label)

# Scale loss and call backward()

scaler.scale(loss).backward()

# Update weights

scaler.step(optimizer)

scaler.update()实际应用和市场影响

向较低精度的过渡不仅仅是一种学术活动;也是一种学术活动。它是推动我们这个时代最重大技术进步的引擎。通过使大规模计算变得可行,FP16 和 FP8 开辟了新的领域。

生成式人工智能和大型语言模型

像 GPT-4 和 Llama 3 这样具有数千亿参数的训练和推理模型只能使用低精度格式。它们大大减少了这些艰巨任务的时间和成本。

科学发现与高性能计算

气候建模、药物发现和材料科学等领域利用降低的模拟精度来容忍微小的错误,但需要巨大的吞吐量,从而加快了研究的步伐。

自治系统

自动驾驶汽车中的实时物体检测和传感器融合需要高速推理。低精度格式可以在功耗和延迟至关重要的边缘设备上加快决策速度。

推荐引擎

Netflix 和 Amazon 等平台用于推荐的海量数据集经过更有效的训练,可以创建更复杂、更准确的模型,从而增强用户体验。

硬币的另一面:挑战和细微差别

虽然好处是革命性的,但采用低精度计算也并非没有挑战。它需要仔细的工程设计和对所涉及的权衡的深刻理解,以避免损害模型的准确性和可靠性。

- 数值稳定性:主要风险是数值溢出(值变得太大)或下溢(值变为零)。损失缩放等技术至关重要,但会增加复杂性。

- 调试复杂性:识别混合精度模型中的发散或精度下降的来源可能比稳定的 FP32 环境更具挑战性。

- 软件和硬件碎片化:不同的硬件支持不同的格式(FP16、BF16、FP8 变体),并且软件必须能够适应。这可能会导致不可移植的代码和供应商锁定。

- 不是通用解决方案:一些算法,特别是科学计算中的算法,对精度误差高度敏感,并且在没有大量研究和验证的情况下无法轻易转换。

供应商分析:三方竞赛

人工智能霸主之战由三个科技巨头展开,每个巨头都有独特的硬件和软件集成战略。

NVIDIA:主导生态系统

NVIDIA 凭借其 Tensor Core 和成熟的 CUDA 软件推动了低精度革命。从 Pascal 到 Blackwell,每一代 GPU 都引入了新的格式和自动化,例如 FP8 的 Transformer Engine,从而巩固了其市场领导地位。

关键区别:紧密集成的硬件和软件生态系统(CUDA)是事实上的行业标准,创造了强大的竞争护城河。

AMD:开源挑战者

AMD 凭借其面向数据中心的 CDNA 架构和面向消费者的 RDNA 已成为强大的挑战者。 Instinct MI300 系列与 NVIDIA 的最佳产品直接竞争,提供海量内存容量和 FP8 支持,所有这些均由开源 ROCm 软件平台提供支持。

关键区别:专注于开放标准 (ROCm/HIP) 和内存容量方面的领先地位,为专有锁定提供强大的替代方案。

英特尔:异构的未来

英特尔的战略以可扩展的 Xe 架构和开放的跨平台 oneAPI 标准为中心。借助 Arc 和 Max 系列 GPU 中的 Xe Matrix Extensions (XMX),英特尔旨在打破供应商锁定,实现跨 CPU、GPU 和其他加速器的无缝计算的未来。

关键区别:倡导针对不同硬件的统一、开放的软件模型(oneAPI),旨在实现软件层的商品化。

软件战场

| 生态系统 | 小贩 | 编程模型 | 到期 | 主要优势 |

|---|---|---|---|---|

| CUDA | 英伟达 | 所有权 | 非常高 | 无与伦比的库支持和开发人员基础。 |

| ROC | AMD | 开源 (HIP) | 中等的 | 开放标准和可移植性工具 (HIPify)。 |

| 一个API | 英特尔 | 开放标准 (SYCL) | 新兴 | CPU、GPU、FPGA 的跨架构愿景。 |

直接比较揭示了一个充满活力的市场。虽然 NVIDIA 占据了峰值性能桂冠,但 AMD 在内存和性价比方面展开了激烈的竞争,将自己定位为强大的替代者。

过滤 GPU

小贩:

英伟达

AMD

精确:

FP8

FP16/BF16

FP4/FP6

性能比较(稀疏 TFLOPS)

| 模型 | 小贩 | 建筑学 | FP8(稀疏) | FP16/BF16(稀疏) | FP4/FP6(稀疏) | 记忆 | 带宽 |

|---|

未来之路:Sub-8 位及以上

对性能和效率的追求是不懈的。该行业已经转向更紧凑的格式,例如 FP6 和 FP4,主要用于人工智能推理。这一趋势提升了智能软件的作用,例如 NVIDIA 的 Transformer Engine,它可以动态管理不断增长的精度。

超越浮点:量化的兴起

对于延迟至关重要的推理工作负载,业界越来越多地采用整数格式(INT8、INT4)。量化将经过训练的浮点模型转换为使用低位整数,从而大大降低计算成本和功耗。虽然此过程可能会导致准确性损失,但量化感知训练 (QAT) 等技术有助于减轻影响,使其成为高效边缘 AI 的基石。

定论

单精度统治的时代已经结束。未来属于能够为整个精密层级提供最智能、自动化、高效管理的生态系统。未来十年的核心挑战将是灵活硬件和掌握它所需的智能软件的复杂协同设计。

© 2025 GigXP.com。版权所有。

本报告是一份独立分析,不隶属于 NVIDIA、AMD 或英特尔。

![如何配对和取消配对 Apple TV Remote [权威指南]](https://pfrlju.com/tech/adelia/wp-content/uploads/2021/08/how-to-pair-apple-tv-remote.webp)

![GSM Prime 工具:完整指南和最佳替代方案 [真实评论]](https://pfrlju.com/tech/avilas/wp-content/uploads/cache/2025/12/gsm-prime-tool-review.jpg)

![[如何&提示]如何使用CMD查找Windows 11产品密钥](https://pfrlju.com/tech/avilas/wp-content/uploads/cache/2025/05/find-windows-11-product-key-cmd.png)