幾天以來,陰謀論一直激動社交網絡:一些用戶聲稱蘋果已經顯示了該詞王牌

當聲音聽起來聽到這個詞種族主義的

。對於某些人來說,不可避免地,這將證明Apple插入的潛意識消息可以操縱其用戶。但事實將在其他地方...

是真的嗎?

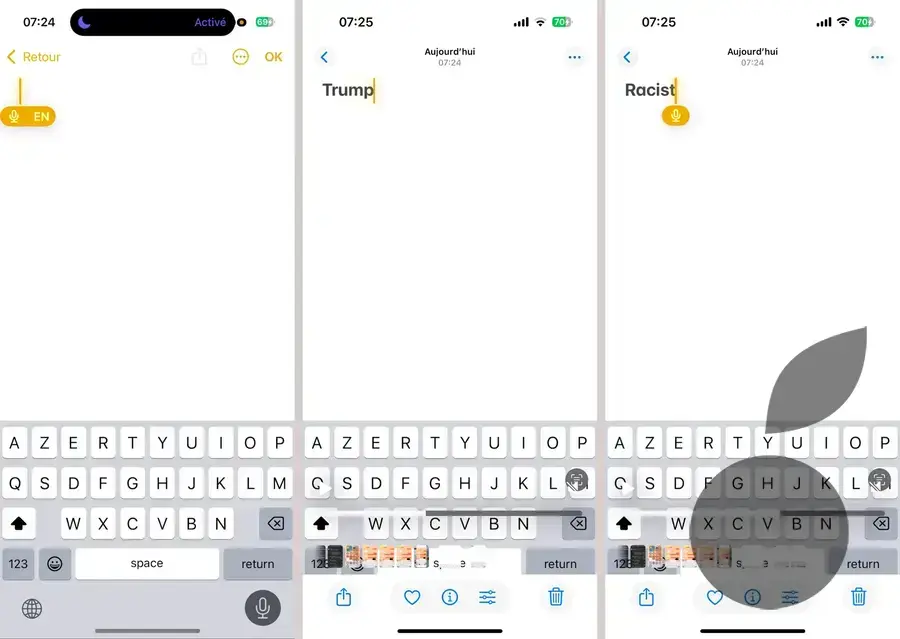

今天早上我起床不可避免,所以我想檢查一下東西。為此,我保留了iPhone 15 Pro的所有法語參數(iOS 18.4 beta 1),但我通過英語通過了鍵盤。我在whatsapp上嘗試了,然後在啟動視頻錄製時注意,然後記下消息等,以跟踪序列。

結果保持不變。每當我發音種族主義的

有了我美麗的口音(VF什麼都沒給),我的iPhone直接顯示了這個詞王牌

在幾秒鐘內,在自動更正之前!

當我要求我的幾個聯繫人到好吧,在上午7點用英語說種族主義詞,以嘗試與其他系統一起重現體驗(其他版本的iOS 18)和其他世代的iPhone)。每個人都像我一樣帶來了同樣的結果,約為80%。

但為什麼?

就其一方面,蘋果做出了迅速的反應,向紐約時報什麼這種現像是由於兩個單詞之間的語音重疊。顯然,對於聽寫算法,種族主義的

等王牌

有時看起來很奇怪,不是語音,而是因為他們經常在同一句子中一起出現。

此錯誤將鏈接自動學習模型的內在功能,控制Apple設備上的聲音說法。後者實際上被吸引到大型數據集以識別單詞並抄錄它們。

所以不,iPhone算法沒有表達位置政策或意見,因為他們不真正理解單詞的含義。他們使用統計模型和關聯。因此,說英語的用戶說的...這讓我們說,在過去的十年中,這個詞特別經常在特朗普的名字附近使用。這種非自願的相關性可能會使模型有偏見,有時會將其推向混淆兩個術語。

為什麼“特朗普”一詞有時會出現,並非總是如此?

今天早上,在我的第一次測試中,首先測試重複了開關。然而,我恢復了體驗的越多,它就越直接顯示正確的單詞。的確,該算法不斷實時調整其理解,並且系統正在通過理解上下文逐漸糾正其錯誤。

這不是蘋果算法第一次犯錯。在2024年,另一個錯誤引起了激烈的爭議:我們擊中巴勒斯坦國旗的自動建議耶路撒冷

。蘋果迅速糾正了錯誤,當他們處理敏感或政治上加載的數據時,再次強調了人工智能係統的限制。

準備的糾正措施

蘋果已經確認,正在準備對這種聲音命令錯誤的糾正。目的可能是重新校準AI模型,以防止非自願關聯引起這種令人尷尬的錯誤。因此,沒有情節,只是對某些算法錯誤的反射,反映了某種情況(對於其他情況)。簡而言之,我讓您得出這種情況的後果...